Hoe Apple-producten steeds slimmer worden dankzij Deep Learning

Heb jij op 15 augustus 2014 gemerkt dat Siri veel slimmer is geworden? Waarschijnlijk niet – en dat is precies wat Apple wil. Achter de schermen zijn ze druk bezig om allerlei vormen van kunstmatige intelligentie in hun producten te stoppen, zonder dat de klant er iets van merkt. In een uitgebreid interview met Eddy Cue, Craig Federighi, Phil Schiller en andere Apple-kopstukken kom je meer te weten over de vele activiteiten die Apple onderneemt om Siri, de Apple Pencil en iOS 10 nog slimmer te maken.

Update 25 augustus: de oorspronkelijke makers van Siri zullen heel anders terugkijken op het verhaal. Zij vonden dat Apple de mogelijkheden van Siri bij de overname sterk beperkt heeft. Inmiddels maken ze de nieuwe assistent Viv:

Deep learning zit in alle producten

Steven Levy is oudgediende op het gebied van Apple-verslaggeving. Hij schrijft al decennialang over Apple, waaronder het vermakelijke boek ‘The Perfect Thing’ (over de iPod) en ‘Insanely Great’ (over de Macintosh). In zijn nieuwste interview op Backchannel vertelt hij over de vele activiteiten die Apple onderneemt op het gebied van kunstmatige intelligentie.

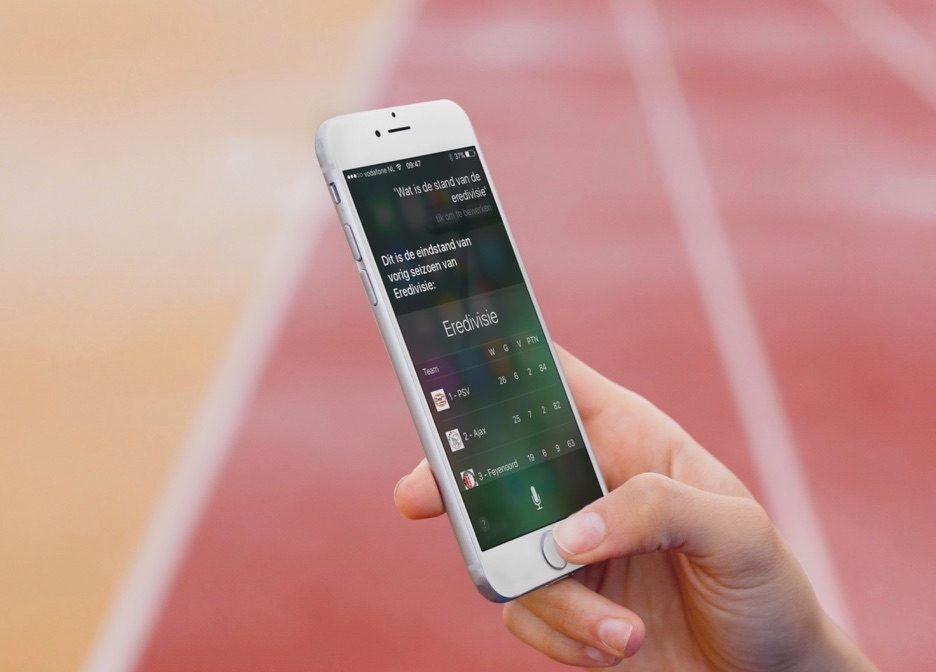

Zo blijkt dat Siri in 2014 overstapte op een nieuw systeem, gebaseerd op neurale netwerken. De eerdere versie van Siri werkte goed, maar maakte ook wel eens wat foutjes bij het interpreteren van opdrachten. Met alleen tweaks zou Apple het niet kunnen oplossen. Daarom stapten ze in juli 2014 over op een nieuw systeem. De rest van de wereld volgde in augustus 2014. Gebruikers merkten er op het eerste gezicht niets van: Siri zag er nog steeds hetzelfde uit, maar de antwoorden werden steeds beter.

Voorbeeld: het gebruiksgemak van de Apple Pencil

Levy kreeg tijdens het interview een twee pagina’s tellende lijst van producten en diensten waarin Apple al gebruik maakt van machine learning en andere slimme technieken. Daarmee wilden ze duidelijk maken dat Apple wel degelijk bezig is met geavanceerde oplossingen voor zelflerende systemen. Maar ze doen het wel op hun eigen manier. Apple gooit je niet dood met whitepapers en wetenschappelijke verhandelingen, maar stopt het stilletjes in producten, die daardoor opeens veel gebruiksvriendelijker zijn. Een goed voorbeeld is de Apple Pencil. Apple had moeite met het feit dat mensen hun handpalm op het scherm leggen tijdens het tekenen. Een machine learning-model voor het negeren van handpalmen bood de oplossing. Het scherm kan sindsdien veel beter onderscheid maken tussen een vingerveeg, een schermtik, een aanraking van de Pencil en het neerleggen van je handpalm. Dat de Apple Pencil zo heerlijk in gebruik is, is te danken aan machine learning.

Siri gaat in iOS 10 vloeiender spreken

Ook in iOS 10 kunnen we weer verbeteringen verwachten die te danken zijn aan machine learning en deep learning, bijvoorbeeld bij Siri. In plaats van losse woordjes die aan elkaar zijn geplakt gaat Apple het uitspreken wat vloeiender laten klinken, zodat Siri meer klinkt als een echte persoon. Misschien verklaart dit ook meteen de opzienbarende uitspraak van Barbra Streisand, die beweerde dat Apple op 30 september een update uitbrengt, die ervoor zorgt dat haar achternaam goed wordt uitgesproken. Misschien had ze het niet over iOS 10 (zoals veel mensen dachten), maar gaat het om een Siri-update die op 30 september stilletjes wordt uitgerold.

Het volledige interview met Eddy Cue, Craig Federighi, Phil Schiller en andere Apple-topmensen vind je op Backchannel.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Deze transparante AirPods kun je niet kopen (11-04)

- Opinie: Aankomende WWDC-keynote wordt belangrijkste Apple-presentatie in jaren (en dit is waarom) (13-03)

- Het einde van de vijftig tinten spacegrijs: overzicht van een van Apple's meestgebruikte kleur (06-03)

- ELEGNT is Apple's robotlamp met menselijke gedragstrekjes (07-02)

- Matter-organisatie belooft beterschap en focust in 2025 op bugfixes bij smart home-standaard (23-01)

Toch vraag ik me af hoeveel mensen Siri elke dag gebruiken? Ik vergeet het steeds.

Ik gebruik het ook zelden, af en toe op m’n Apple Watch.

Hoe zou de officiële uitspraak zijn van mevrouw Streisand? We vragen het Siri 30 september.. ben zeer benieuwd!

Ik gebruik Siri helemaal niet.

Haha, ‘deep learning’ of ‘hardlearning’?

Geduld, over 2-5 jaar doe je niet anders. Virtuele assistenten en perfect voice recognition zijn ook een must voor de virtual reality revolutie.

Ik gebruik Siri regelmatig voor HomeKit en op de Apple Watch. Het zetten van een wekker, timer of een herinnering gebruik ik ook af en toe. Verder niet erg veel want het antwoordt is altijd “Ik weet niet wat u bedoelt met …. zal ik het op het internet voor u opzoeken?”

Ik gebruik siri bewust niet. Mijn ogen zijn nog goed en mijn motoriek ook. Spotlight gebruik ik ook niet. Ik vraag me af of het niet goed zou zijn om naast de supergeavanceerde produkten ook iets meer eenvoudigers op de markt te brengen. Straks betalen we voor allerlei functies die we niet willen. Customisatie?

@Marc: ik elke dag. Vooral op de Watch

Laat die Apple maar een keer deep learning hoe ze een update uit kunnen brengen zonder al dat gezeur achteraf. Als dat lukt stap ik af van mijn lumia950xl en Linux Phone.

Het is nog steeds waardeloos, je kan niet eens om een uitslag vragen van een voetbal wedstrijd. Als ik in de auto rij en vraag, vertel mij of er een file op de A1 is, dat laat hij een schermpje zien ipv dat het wordt op gelezen, en daar is nog weinig aan veranderd. Ik wil niet kijken op het scherm van mijn telefoon als ik rij. Dat start ik flitsmeister maar weer via mijn stem en die zegt tenminste dat er een vertraging aankomt hoe lang het ongeveer duurt.

@Marc: ik tijdens het rijden, gewoon even snel de home knop indrukken en ‘bel *naam*’ zeggen.

En heel af en toe vraag ik of Siri(of hoe heet de mannelijke versie?) mij leuk vind…. Is dat raar?

Als Siri ja zegt wel 😄

Siri’s woordenschat mag ook beter. Zelfs in het Engels herkent ze érg veel woorden gewoon niet. Woorden die al jaren in ’t woordenboek zijn opgenomen. Woorden waar ik de definitie om vraag, kan ze zelf niet verstaan, terwijl ik ze fonetisch compleet correct uitspreek. Dit is toch een van de basisfuncties? Ongelofelijk dat het niet naar behoren werkt.

@iHavethesolution: vond ik wel adrem.