Waarom 2023 een spectaculair Apple-jaar wordt, dankzij Stable Diffusion

Dit is Stable Diffusion

Apple kondigde afgelopen week aan dat er optimalisaties voor Stable Diffusion in Core ML zijn toegevoegd in iOS 16.2 en macOS 13.1. Ook is er nu code om aan de slag te gaan met Stable Diffusion op Apple Silicon-apparaten. Volgens Robert Scoble is het “huge”. Apple zou een mesh-netwerk hebben ontwikkeld. Dat is nu nog niet ingeschakeld maar zal in 2023 een hoop leuke toepassingen mogelijk maken. Toch is het voor veel mensen maar moeilijk in te schatten wat je eraan hebt. Het is dan ook ingewikkelde materie en het is moelijk om je voor te stellen hoe dit gaat werken op de nog niet aangekondigde AR/VR-bril van Apple. Op deze pagina proberen we wat meer duidelijkheid te geven.

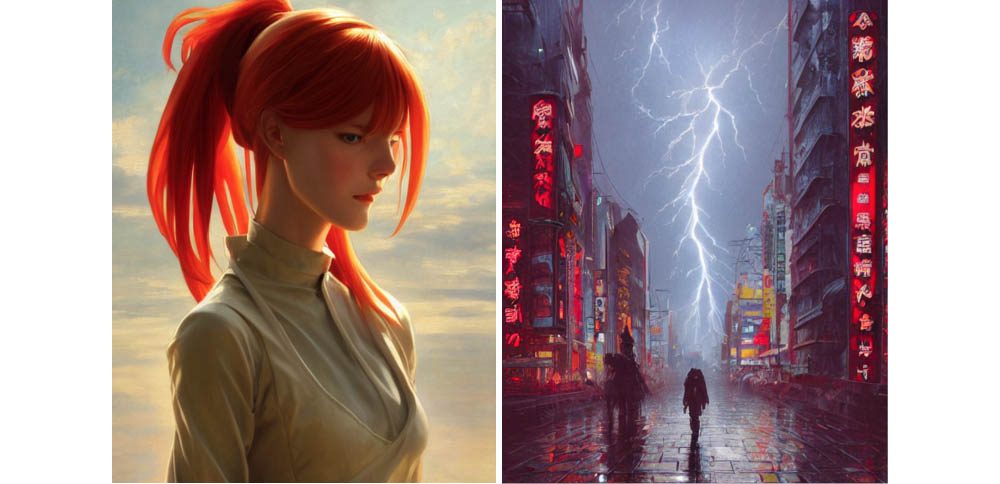

Stable Diffusion is een deep learning-model waarmee tekst naar afbeeldingen kan worden omgezet. Zo kun je bijvoorbeeld vragen: “Laat Tim Cook in een gebloemde trui zien” en er wordt een gedetailleerde afbeelding gemaakt van iemand die op Tim Cook lijkt in een gebloemde trui. Een ander voorbeeld dat vaak wordt gebruikt is: “Laat een astronaut op een paard zien.” Dat levert dan dergelijke afbeeldingen op:

De aankondiging van Apple houdt in dat er optimalisaties zijn doorgevoerd, waardoor je het genereren van AI-afbeeldingen kunt uitvoeren op Apple Silicon met behulp van Core ML. Core ML is Apple’s eigen raamwerk voor machine learning-modellen. Appontwikkelaars kunnen de Neural Engine in Apple-devices gebruiken om Stable Diffusion tweemaal zo snel te laten draaien in vergelijking met eerdere Mac-methoden.

Grote sprongen vooruit

Apple heeft ook uitgebreide documentatie en voorbeeldcode uitgebracht, om te laten zien hoe StableDiffusion-modellen naar Core ML kunnen worden overgezet. Daarmee laat Apple voor het eerst zien dat ze flink hebben geïnvesteerd in het genereren van afbeeldingen met kunstmatige intelligentie. Op dat punt zijn grote sprongen vooruit gemaakt, dankzij het DALL-E model. Je geeft daarbij een omschrijving wat je wil zien en er wordt een afbeelding van gemaakt. Je kunt er ook andere taken mee uitvoeren, zoals het laten schrijven van een uitgebreide tekst op basis van een simpel geformuleerde opdracht zoals: “Schrijf een artikel over 10 voordelen van de iPhone ten opzichte van Android”.

De variant Stable Diffusion is sinds augustus 2022 beschikbaar en is goed ontvangen. Je hebt er wel zware hardware voor nodig, maar dat heeft Apple in huis met Apple Silicon en de Neural Engines in huidige Macs. Apple zegt dat een standaard MacBook Air M2 een Stable Diffusion-model met 50 iteraties in 18 seconden kan genereren. Een iPad Pro M1 doet het in een heel redelijk tijdsbestek van minder dan 30 seconden. Apple heeft hiermee de tijd om afbeeldingen te genereren gehalveerd.

Apple’s insteek is dat Stable Diffusion op lokale devices (oftewel iPads, Macs en misschien zelfs iPhones) kan worden gebruikt, zonder afhankelijk te zijn van clouddiensten. Dit is beter voor je privacy en bespaart kosten omdat je niet hoeft te betalen voor verwerking in de cloud. Het vindt immers plaats op je lokale hardware, waarvoor je zelf de stroomrekening betaalt. Als de bewering van Robert Scoble klopt wordt daarbij een mesh-netwerk van meerdere devices gebruikt – van jezelf en misschien ook van anderen.

Snelheidsrace tussen Nvidia en Apple Silicon

Apple benadrukt ook dat je na de aanvankelijke download geen internetverbinding meer nodig hebt om het model te gebruiken. De snelste manier om Stable Diffusion-afbeeldingen te genereren is op high-end grafische processoren van Nvidia die lokaal draaien op een Windows- of Linux-pc. Ter vergelijking: het genereren van een 512 x 512 pixel afbeelding neemt op een RTX 3060 ongeveer 8,7 seconden in beslag. De conventionele methode op een Mac mini M1 neemt 69,8 seconden in beslag. Dit is volgens Apple nu teruggebracht naar 35 seconden op een M1-chip. Apple’s meest krachtige chip M1 Ultra doet er nog maar 9 seconden over en komt dus in de buurt van Nvidia.

Waar komt Stable Diffusion vandaan?

Stable Diffusion wordt aangeboden door Stability AI, een organisatie die in oktober ruim 100 miljoen dollar investeringsgeld kreeg om de technologie verder te ontwikkelen. De engine is ontstaan uit een samenwerking tussen Stability AI, Runway ML, onderzoekers van de universiteit van Heidelberg, de grassrootsbeweging EleutherAI en LAION (Large-scale Artificial Intelligence Open Network). De generator is getraind met een subset van de beelddatabank LAION-5B, die 5 miljard items omvat. LAION-5B slaat zelf geen afbeeldingen op, maar bevat alleen verwijzingen naar afbeeldingen die op internet beschikbaar zijn en voorzien zijn van tekstbeschrijving. Of je de gegenereerde afbeeldingen zomaar kunt gebruiken, is nog maar de vraag aangezien de eigenaren van de oorspronkelijke afbeeldingen nooit toestemming hebben gegeven om ze te remixen tot iets nieuws. Of het eindresultaat beter is dan het origineel, is uiteraard een kwestie van smaak.

Zelf aan de slag met Stable Diffusion

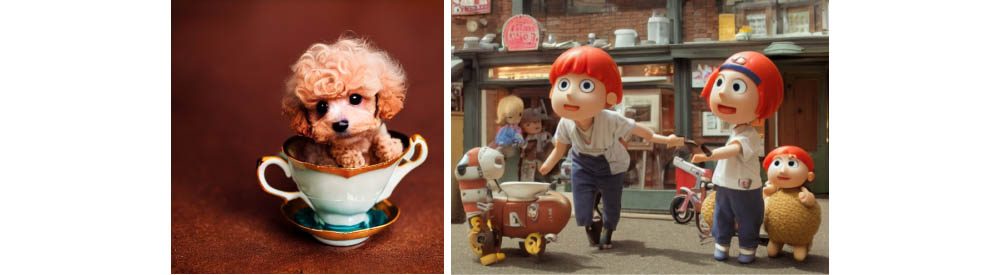

Wil je er nu al mee aan de slag, dan kun je de app Diffusion Bee gebruiken. Die is nog niet geoptimaliseerd voor Apple’s nieuwe optimalisaties, maar is al wel te gebruiken op Apple Silicon Macs. Ook is er de app Draw Things, waarmee je met Stable Diffusion op de iPhone en iPad kunt experimenteren. Tik een omschrijving in en de app genereert binnen een paar minuten een afbeelding. Alles wat je kunt verzinnen is denkbaar. Een hond in een theekopje? Waarom niet?

Maar de echt mooie toepassingen gaan we waarschijnlijk pas zien als Apple’s mixed reality-headset beschikbaar komt, waarmee naar wens elke gewenste afbeelding kan worden gegenereerd.

Wil je als ontwikkelaar ermee aan de slag, dan kun je met Apple’s GitHub-release bezig. Dit is een Python-package die Stable Diffusion-modellen van PyTorch omzet naar Core ML. Het is geschikt voor Stable Diffusion 1.4, 1.5 en de nieuwste versie 2.0. Om Stable Diffusion met Core ML lokaal op een Mac te kunnen draaien heb je wat kennis van de commandoregel nodig. In deze gids van Hugging Face lees je uitleg hoe je het werkend krijgt.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Apple Silicon

Apple Silicon is Apple's eigen lijn chips voor de Mac, maar zijn ook te vinden in sommige iPad-modellen. De M1-chip was de eerste Apple Silicon-chip, gebaseerd op de structuur van ARM. Daarna volgden de M2-chip, M3-chip, M4-chip en diverse varianten en opvolgers. Apple Silicon chips zijn door Apple zelf ontworpen en zorgen voor betere prestaties, batterijduur en meer. Macs met Apple Silicon hebben een aantal voordelen, maar er zijn ook wat nadelen die je ontdekt door onze artikelen te lezen.

- Alles over Apple Silicon

- Alles over de M4-chip

- Alles over de M3-chip

- Alles over de M2-chip

- Alles over de M1-chip

- Intel vs Apple Silicon

- MacBook Air met Apple Silicon

- MacBook Pro met Apple Silicon

- iMac met Apple Silicon

- Mac mini met Apple Silicon

- Mac Studio met Apple Silicon

- Mac Pro met Apple Silicon

Draw things op iPhone werkt niet echt lekker. Vaak krijg ik maar een half plaatje te zien.

Denkt dat het alleen goed werkt op de nieuwere versies…

Op iPad Pro M1 hier draait het prima een relatief vlot.

Een rtx3060 vergelijken met een M1 ultra is natuurlijk kolder.

De rtx3060 is een midden segment gamer kaart van rond de 400 euro. De M1 ultra in een Mac studio, goedkoopste versie € 4.629,00 bij Apple. Doe het dan ook goed en vergelijk het met een rtx3080ti of rtx3090 of een ontwikkelkaart en geen gamer spul.