Update 3 september 2021: Apple stelt de CSAM-maatregelen een paar maanden uit na kritiek van beveiligingsexperts en feedback van gebruikers.

Veiliger voor kinderen

Het gaat om drie functies die op verschillende plekken in iOS, iPadOS en macOS te vinden zijn. Zo komt er een nieuw systeem om materiaal met kindermisbruik te detecteren, iets waar we vandaag al eerder over schreven. Op dat moment ging het nog om geruchten, nu heeft Apple de volledige reeks maatregelen onthuld. Op deze pagina staan ze allemaal opgesomd.

Alle maatregelen die Apple aangekondigd heeft, worden in eerste instantie alleen in de VS ingevoerd. Mogelijk volgt later nog een verdere uitrol.

#1 Apple gaat iCloud Foto’s scannen

Ze moeten voorkomen dat zogenaamd CSAM (Child Sexual Abuse Material) zich verspreidt. Kinderen brengen veel tijd online door en lopen daarbij risico’s om ongeschikt materiaal onder ogen te krijgen. Tegelijk lopen kinderen het risico dat ze zelf worden vastgelegd in schokkend beeldmateriaal. Alle drie functies zijn geoptimaliseerd voor privacy. Dat houdt in dat Apple wel informatie over criminele activiteiten kan doorgeven aan de activiteiten, maar dat de privacy van brave burgers niet in het geding is.

Het scannen van iCloud Foto’s is het belangrijkste onderdeel. Als er CSAM wordt ontdekt zal het betreffende account worden voorzien van een vlaggetje. Apple zal het ook rapporteren aan een organisatie voor zoekgeraakte kinderen en zal medewerking verlenen aan wetshandhavingsinstanties in de VS. Apple benadrukt dat het voorlopig alleen in de VS gebruikt gaat worden. Mogelijk volgt er later nog een verdere uitrol.

https://twitter.com/matthew_d_green/status/1423093261405667328

Apple scant de foto’s niet, maar gebruikt intelligentie op het apparaat om de CSAM te matchen met een database van reeds bekende foto’s, die zijn omgezet naar onleesbare hashes. Dit is een ingewikkeld proces waarbij gebruik wordt gemaakt van cryptografische technieken, om de privacy te garanderen.

Een verdacht account zal worden geblokkeerd na een handmatige inspectie. Gebruikers kunnen protest aantekenen als ze vinden dat hun account onterecht is afgesloten. Het geldt alleen voor iCloud Foto’s en niet voor foto’s die lokaal op het toestel staan.

Een uitgebreide technische uitleg vind je hier in PDF-formaat.

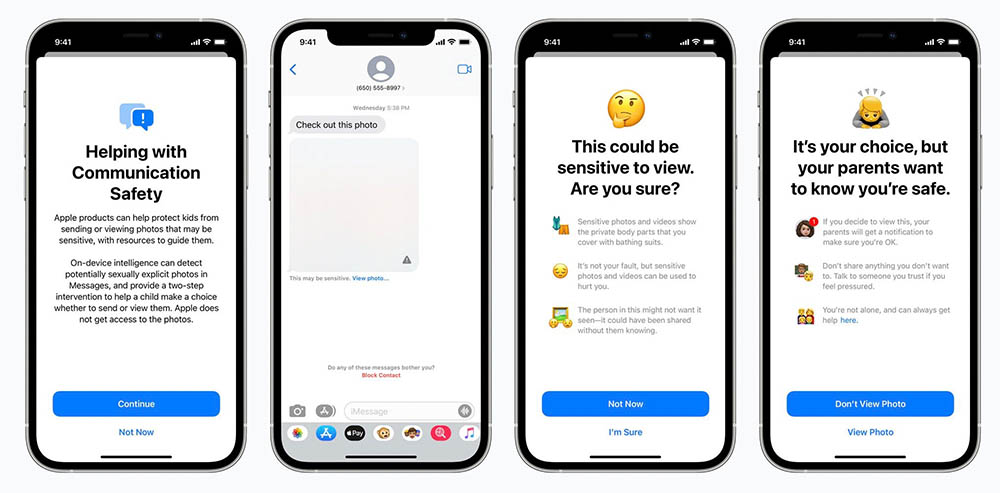

#2 Meer veiligheid bij iMessage-gebruik

Apple gaat ook nieuwe functies invoeren om te zorgen dat ouders op de hoogte zijn hoe hun kinderen online communiceren. Als kinderen een seksueel getinte foto ontvangen, zal deze automatisch onscherp worden gemaakt en krijgen ze een waarschuwing. Willen ze de foto toch bekijken, dan zal het bericht ook aan de ouders worden doorgestuurd.

Ook hierbij wordt gebruik gemaakt van machine learning om foto’s te analyseren en te bepalen of het om expliciete beelden gaat. Apple ontvangt geen kopie van de foto.

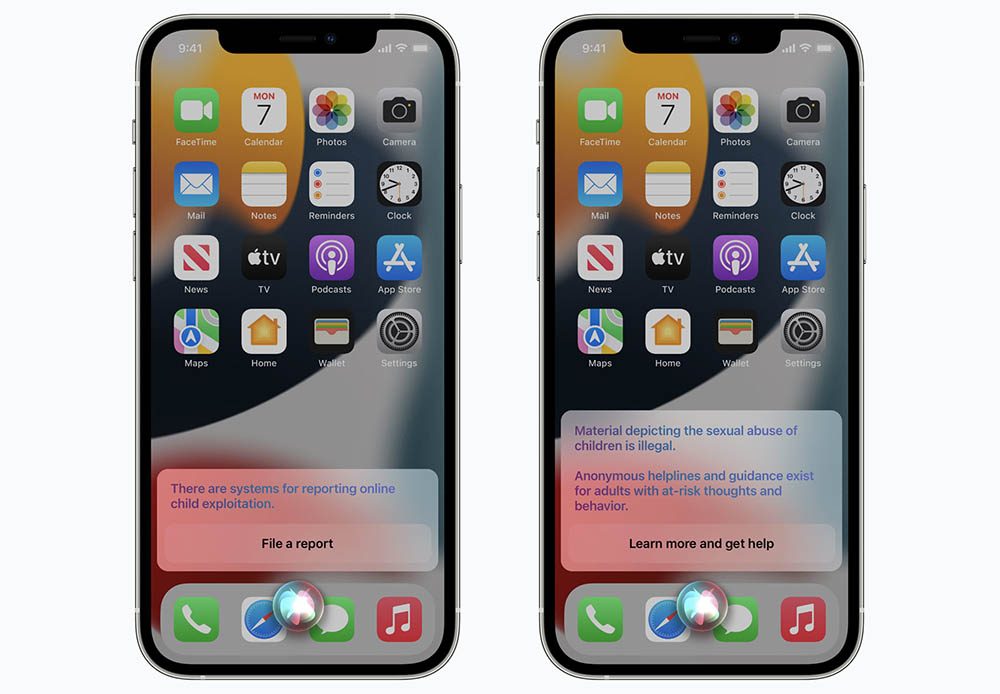

#3 Siri en zoeken helpen je verder

Ook Siri en zoeken worden veiliger voor gebruikers. Je kunt bijvoorbeeld Siri om hulp vragen als je met CSAM geconfronteerd wordt. Siri stuurt je dan door naar de juiste bronnen. Apple benadrukt dat er niet alleen op privacy is gelet, maar ook op mogelijk misbruik door overheden in landen waar het minder veilig is. Ook is de versleuteling niet verzwakt om deze nieuwe tools mogelijk te maken. End-to-end versleutelde foto’s kunnen niet worden geanalyseerd.

Toch zijn beveiligingsonderzoekers niet helemaal gerust. Apple baseert zich op een database met hashes die niet geraadpleegd kan worden. Blijkt een onschuldige foto dezelfde hash te hebben als een bekende CSAM, dan valt voor jou als gebruiker moeilijk te bewijzen dat het om twee heel verschillende foto’s gaat.

- 2021 - 03 september: De CSAM-functie is een paar maanden uitgesteld.

- 2021 - 06 augustus: Link naar de nieuwe FAQ toegevoegd waarin we de belangrijkste vragen beantwoorden en de kritiek op Apple's maatregelen verder uitlichten.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Apple werkt aan verbeteringen voor Apple Intelligence: zo gaat Apple dat doen (15-04)

- Apple is voor het eerst grootste smartphoneverkoper ter wereld in eerste kwartaal (dankzij deze iPhone) (15-04)

- Apple viert 10 jaar Activiteit-app met speciale uitdaging (en een exclusieve fysieke pin) (14-04)

- Gerucht: 'Apple Intelligence-versie van Siri komt nog dit najaar' (14-04)

- Wanneer werkt Apple Intelligence in het Nederlands? Dit is wat we nu weten (07-04)

De iPhone en iPad voor kinderen

De iPad en iPhone zijn ook leuk voor kinderen. Met deze artikelen zorg je dat kinderen ze veilig kunnen gebruiken, met onder andere informatie over delen met gezin, ouderlijk toezicht, tijdslot instellen en leuke apps vinden. En met Schermtijd beperk je de tijd die kinderen (of jijzelf) kunnen doorbrengen op de iPhone en iPad. Ook lees je hoe je een Apple ID voor kinderen kunt aanmaken.

- Ouderlijk toezicht gebruiken

- Schermtijd op iPhone en iPad

- Applimieten instellen in Schermtijd

- Begeleide toegang gebruiken

- iPad-gebruik van kinderen beperken

- Geschikte apps voor oudere iPad zoeken

- Leerzame programmeerapps voor kinderen

- Tijdslot voor kinderen instellen op iPhone en iPad

- Thuisknop blokkeren op de iPad

- iPad-apps filteren op leeftijd

- iPad kindveilig maken met beschermhoezen

- Apps voor kinderen tijdens lange autoritten

- Meldingen uitschakelen op een gezamenlijke iPad

- In-app aankopen uitschakelen

- Alles over Delen met gezin

- Apple ID voor kinderen

Tijd dus om iCloud foto’s uit te schakelen. Heb ik gelijk maar gedaan, en ook al mijn oude foto’s van iCloud afgehaald. Privacy gaat boven alles.

Want je hebt foto’s met kinderen?

Als Apple je foto’s wilde bekijken hadden ze dat allang gedaan hoor

Heel mooi geformuleerd door iCulture…maar dit is een enorme stap in het “wij beschermen uw privacy verhaal” en zijn de Good Guy gebeuren.

“Apple scant data van al haar users” zou er moeten staan. Vandaag alleen om Y te voorkomen, morgen om Z te voorkomen en overmorgen om Q van informatie te voorzien.

Dus Apple gaat (nu publiekelijk) ordinair de data van gebruikers doorzoeken. Hoe zat dat met alles is versleuteld, kunnen we niet bij. Vandaag in de cloud, morgen helpt de ki Chip op het toestel?

Google is misschien toch niet zo evil, beide partijen doen niet onder voor elkaar.

Ik snap het, maar toch vraag ik me ook af of ik dan nog wel mijn foto’s in icloud wil blijven bewaren. Wat zijn goede alternatieven die ook een goede app erbij hebben die vergelijkbaar of beter zijn met de foto’s en bestanden app van Apple? Als ik dat hier mag vragen…

Aan de ene kant vind ik het goed dat ze hier aan denken maar dan moeten ze wel de privacy niet verloren laten gaan!

Ik mis de kritische blik in het artikel Gonny, klinkt allemaal heel goed bedoeld, maar lijkt een kleine stap met forse inbreuk op de privacy

Zijn ze knettergek geworden daar bij Apple. Natuurlijk een geweldig streven om kinder misbruik tegen te gaan. Maar zeggen ze zelf niet altijd dat als je de deur voor één ding open zet, hij altijd openstaat?

En juist deze week? Nadat blijkt dat duistere regimes via Pegasus software iPhones kunnen ‘ownen’

Het allerergste vind ik dat het niet eens in de cloud gebeurd, maar op het toestel zelf. Gruwel.

Een ongelooflijke inbreuk op privacy en veiligheid van je informatie. Dezelfde privacy en veiligheid die Apple bij iedere presentatie als Unique Selling Point verkoopt. 🤦🏻♂️

Ik heb geen foto’s van kinderen. Maar dat is altijd de eerste stap die ze nemen. Straks is het ook voor foto’s die politiek minder welgevallend zijn. Er zijn genoeg redenen om dit niet te willen.

We hoeven hier niet te discussiëren over de noodzaak om kinderen te beschermen, hier zal iedereen het over eens zijn. Waar ik me wel zorgen over maak is de manier waarop Apple haar aandeel in dit streven wil leveren en hoe zich dit verhoudt tot haar eigen policy “Privacy is een fundamenteel mensenrecht. En is daarom ook een van de kernwaarden van Apple”. Feitelijk zegt Apple dat de privacy op jouw telefoon een fundamenteel mensenrecht is, maar dat ze voor de zekerheid toch graag even met je mee kijken. Het feit dat AI verre van feilloos is maakt het extra griezelig. Daarnaast moet je je afvragen of hiermee het hek van de dam is. Gaan ze in de toekomst ook scannen op heel veel andere zaken (geweldsdelicten, wapens, specifiek zoekgedrag op het web, gezondheid en ga zo nog maar even door). Kortom, ik vraag me af of Apple hier goed aan doet.

De strekking van het artikel op iCulture komt op mij behoorlijk “luchtig” over en steekt schril af tegen de discussies die op diverse plekken gevoerd worden.

Dit is wederom een storm in glas water hoor. Lees dit even na.

En ook dit komende van MacRumors:

@Frederik: Is het daarom minder zorgwekkend?

Het is alomtegenwoordig, en het gebeurt al jaren met andere big tech (die iedereen sowieso ook al gebruikt). Je kan ook opteren om al je sociale media te wissen, geen smartphone meer te gebruiken, en echt werkelijk alles offline te gaan doen. Veel plezier. 🙂

Ik lig er inderdaad niet wakker van. Ik ben me bewust van de prijs van permanent online te zijn en dat heb ik er voor over. Het comfort is me meer waard.

We wachten even af tot de KI een misser bij deze mijnheer maakt, hij op zwarte lijsten komt te staan, subject van onderzoek wordt, de molen gaat draaien. Of dat iemand via een achterdeur of bug iets in de cloud van deze mijnheer plaats en het hele circus automatisch opstart.

Geen probleem, want de big tech doet dit toch al lang, dus ach, laat maar gaan of anders gewoon je mond houden en offline gaan. Wetende dat deze scanners complete profielen kunnen maken (ja, ik lees het antwoord al, doen ze niet want ze zijn goed voor ons)

Het is gigantisch belangrijk dat de discussie op gang komt. Dat snapt deze mijnheer die zijn privacy niet belangrijk vindt en niets te verbergen heeft op zijn laatst als men op basis van zijn data verkeerde conclusies gaat trekken of er andere bugs optreden die niet binnen het automatische proces vallen. Mijnheer? U een verzekering bij ons, sorry hoor. U wilt naar Amerika? Helaas mijnheer, u komt hier niet binnen. Waarom? Kunnen we u niet vertellen. En zo zijn er nog 100 scenario’s.

Mijn data hoort bij mij en ik kies met wie ik deze deel. Versleuteling behoort een standaard optie te zijn voor een betaald(!) product. Als deze mijnheer er dan voor kiest zijn data te delen, prima.

Waarom is dat het allerergste? Het lijkt me juist goed als het op het toestel zelf gebeurt in plaats van in de cloud. Op je toestel kunnen ze niet naar je foto’s kijken, in de cloud wel. Op je toestel scanden ze de foto’s al lang trouwens, om bijvoorbeeld gezichten en dieren te herkennen zodat die makkelijk vindbaar zijn voor je. Niets van deze data wordt naar Apple gestuurd, in tegenstelling tot veel andere gelijkwaardige toepassingen.

@Frederik: Het probleem hier is dat Apple het op je iPhone controleert: ze gebruiken dus jouw CPU-tijd (en elektriciteitskosten) om het te controleren. Bij Microsoft, Facebook en Google doen ze het serverside. Hoewel ik hier ook geen voorstander van ben, vind ik dat minder indringend omdat ze je privétoestel (hardware) “respecteren”. Wat Apple doet, is gelijkaardig aan een permanente huiszoeking.

@Jaap Couro: Mijnheer, we wachten even rustig af, inderdaad. Vergeet in tussentijd niet dat er nog steeds een manueel review proces aan te pas komt indien je account (al dan niet onterecht) geflagd wordt voor malafide content. Sinds iCloud 2FA gebruikt is er bij mij alvast meer vertrouwen dat mijn data veilig is en dat niet Jan Modaal even wat foute foto’s kan injecteren in mijn account. Maar kijk, iedereen is vrij om al dan niet bij Apple te blijven. Simpel.

Ik denk niet dat de energiezuinige 16 core neural engine van de A14 Bionic processor met zijn 11 biljoen operaties per seconde daar wakker van ligt. Ik denk ook niet dat wij dat gaan voelen in onze jaarlijkse energiefactuur. 😀 Het is net daarentegen veel indringender dat het bij andere bedrijven server-side gebeurt. Maar als Belg zijnde begrijp ik uiteraard dat deze denkpiste van jou waarschijnlijk toebehoort aan de zuinige ingesteldheid van de Nederlander. Halve euro per jaar besparen aan oplaadkosten en lekker alles server-side bij Google.

(Red.) Link naar de nieuwe FAQ toegevoegd waarin we de belangrijkste vragen beantwoorden en de kritiek op Apple’s maatregelen verder uitlichten.

apple gaat alleen in de cloud scannen , niet wat er op je telefoon staat.

Alles wat op de servers van Apple staat, of te wel in de cloud, is eigendom van Apple. Je hebt die informatie zelf in de cloud gezet. Apple is dus indirect verantwoordelijk voor wat er op zijn servers staat. Als je data op een usb-stick zet of op een CD brand, dan heeft er niemand recht op jou data jij bent dan de enige eigenaar. Dat al die IT bedrijven niks doen met al die data in de cloud is een utopie.

Niet correct… Apple gaat op je telefoon scannen….

Heel zorgwekkend, gezien de huidige maatregelen van het inperken van allerlei grondrechten, nu lijkt ook Apple dit verkeerde pad in te slaan. Een slechter moment konden ze niet kiezen. Big Tech is watching you & World Economic Forum. Gaan ze straks ook de critici van wat Apple “normaal” vindt rapporteren? Het wordt tijd om iCloud te minimaliseren en uit te gaan kijken naar een service provider die wel complete privacy garandeert! Heeft iemand een suggestie?

(Red.) De CSAM-functie is een paar maanden uitgesteld.