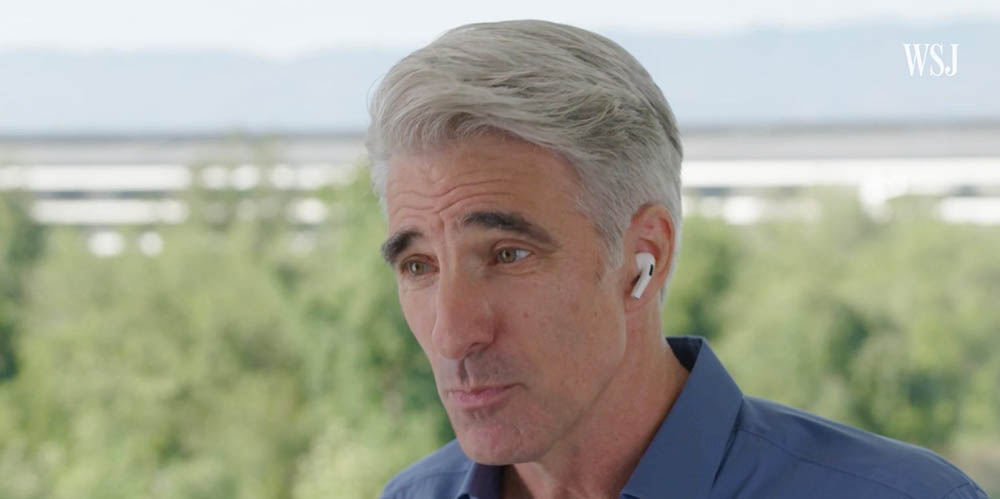

In een video-interview met Joanna Stern van de Wall Street Journal, gaat Federighi in op de reacties die zijn ontstaan na de aankondiging van nieuwe functies om kinderen te beschermen. Federighi geeft toe dat het aankondigen van twee heel verschillende maatregelen niet goed is aangepakt. Enerzijds wil Apple iCloud-foto’s gaan controleren op kindermisbruik, terwijl Apple tegelijk wil waarschuwen als kinderen naaktfoto’s via iMessage-berichten willen versturen. Dit werkt op twee heel uiteenlopende manieren en het doel is ook heel verschillend. Daardoor heeft Apple verwarring gecreëerd, geeft Federighi toe.

In het gesprek met WSJ benadrukt Federighi nogmaals dat CSAM-scannen alleen plaatsvindt bij foto’s die je naar iCloud wil uploaden. Vervolgens vindt de controle van die foto lokaal op het toestel zelf plaats. Schakel je iCloud-foto’s uit, dan zullen je foto’s niet worden gecheckt op CSAM-content.

Niet goed aangepakt

Federighi denkt dat Apple het verkeerd heeft aangepakt:

We hadden gewild dat dit wat duidelijker naar voren was gekomen, want wij voelen ons zeer positief en sterk betrokken bij wat wij doen. Maar we zien dat het op grote schaal verkeerd is begrepen.

Ook had Apple niet twee heel verschillende functies tegelijk moeten onthullen:

Achteraf gezien was het tegelijkertijd introduceren van deze twee functies een bron van verwarring. Door ze op hetzelfde moment uit te brengen, gingen mensen ze technisch met elkaar in verband brengen en vreesden ze: “Wat gebeurt er met mijn berichten? Het antwoord is… er gebeurt niets met je berichten.

Nou, behalve dan dat berichten bij kinderen van 12 jaar en jonger op blote inhoud wordt gecontroleerd, als de ouders dit inschakelen. Maar het is dan dus een persoonlijke keuze.

Limiet van 30 foto’s

Apple benadrukt dat er gebruik gemaakt wordt van hashes, die worden vergeleken met een database van bekende kinderpornofoto’s. Een account wordt echter niet meteen als verdacht gemarkeerd als er één plaatje wordt gedetecteerd. Om te voorkomen dat er bij valse positieven te snel wordt ingegrepen heeft Apple een minimum limiet ingesteld voor het aantal keren dat content is ontdekt. Gebeurt dat, dan zal het account worden gerapporteerd aan een intern team, dat de foto’s gaat bekijken. Uiteindelijk wordt het account ook bij NCMEC (National Center for Missing & Exploited Children) gemeld. Het scannen van foto’s gebeurt aanvankelijk alleen in de VS.

Apple heeft in het begin niet duidelijk gemaakt dat er limiet zou gelden. In het interview laat Federighi nu weten dat het “iets in de orde van 30 bekende pornoplaatjes” gaat. Dit getal wordt ook genoemd in een nieuw document dat Apple online heeft gezet (zie verderop).

Ook benadrukt hij dat bij accounts die als mogelijk verdacht worden gemarkeerd, alleen de gevonden foto’s worden bekeken door mensen. Het is dus niet zo dat Apple-medewerkers door je gehele fotobibliotheek gaan zitten bladeren.

Niet onder druk gezet

Op de vraag of Apple onder druk is gezet om de CSAM-functie in te voeren, zegt Federighi dat er geen sprake van is:

Nee, het kwam er echt op neer dat… we het uitzochten. We wilden iets maken, maar niet iets waarbij alle klantgegevens gescand zouden worden.

Een andere zorg waar veel gebruikers en privacy-experts zich druk over maken, is of Apple niet de deur openzet voor een achterdeurtje. Federighi verwerpt deze suggestie sterk. Apple heeft voor het systeem meerdere auditing-systemen ingebouwd, waardoor het systeem niet misbruikt kan worden. Verder zal dezelfde database met hashes wereldwijd worden gebruikt, dus er komt geen speciale variant voor China. Het is niet zomaar mogelijk om andere foto’s aan de database toe te voegen. De foto’s moeten in ieder geval in twee verschillende CSAM-databases staan, in verschillende jurisdicties, zodat het systeem niet misbruikt kan worden voor andere dingen. Apple geeft echter geen inzicht in de inhoud van de database zelf. De betrokken organisaties voeren samen met een onafhankelijke auditor controles uit.

Federighi lijkt de ophef onder beveiligingsonderzoekers wat overdreven te vinden, aangezien alles voor hen inzichtelijk is:

Omdat het op de telefoon gebeurt, zijn beveiligingsonderzoekers constant in staat om te kijken wat er gebeurt in Apple’s software. Dus als er veranderingen zouden worden aangebracht die de reikwijdte op een of andere manier zouden uitbreiden – op een manier die we niet hadden beloofd te doen – dan is dat te controleren. Ze kunnen zien wat er gebeurt.

Nieuw document geeft uitleg

Wil je nog meer weten over de gang van zaken, dan heeft Apple een uitgebreider document uitgebracht, waarin de beveiliging en privacy van de CSAM-detectie nader wordt uitgelegd. De achterliggende uitgangspunten qua design, beveiliging en privacy worden daarin duidelijker besproken. Veel details die in het interview met Craig Federighi naar voren kwamen, staan nu nog eens duidelijk zwart op wit, zoals de limiet van 30 bekende CSAM-afbeeldingen, voordat een iCloud-account als verdacht wordt gemarkeerd.

Apple zal ook een supportdocument uitbrengen met de root hash van de versleutelde CSAM hash-database die gebruikt gaat worden in elke versie van Apple’s besturingssystemen. Gebruikers kunnen de root hsh op hun toestel controleren met die van de versleutelde database, om zeker te zijn dat er (bijvoorbeeld door een kwaadwillende aanval) stiekem gebruik wordt gemaakt van een heel andere database met bijvoorbeeld politieke foto’s.

Het document is hier te vinden (PDF). Daarnaast vind je veel antwoorden in onze CSAM FAQ.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Apple geeft je 10% korting op accessoires bij inlevering van je oude apparaat (van welk merk dan ook) (16-04)

- Apple werkt aan verbeteringen voor Apple Intelligence: zo gaat Apple dat doen (15-04)

- Apple is voor het eerst grootste smartphoneverkoper ter wereld in eerste kwartaal (dankzij deze iPhone) (15-04)

- Apple viert 10 jaar Activiteit-app met speciale uitdaging (en een exclusieve fysieke pin) (14-04)

- Gerucht: 'Apple Intelligence-versie van Siri komt nog dit najaar' (14-04)

De iPhone en iPad voor kinderen

De iPad en iPhone zijn ook leuk voor kinderen. Met deze artikelen zorg je dat kinderen ze veilig kunnen gebruiken, met onder andere informatie over delen met gezin, ouderlijk toezicht, tijdslot instellen en leuke apps vinden. En met Schermtijd beperk je de tijd die kinderen (of jijzelf) kunnen doorbrengen op de iPhone en iPad. Ook lees je hoe je een Apple ID voor kinderen kunt aanmaken.

- Ouderlijk toezicht gebruiken

- Schermtijd op iPhone en iPad

- Applimieten instellen in Schermtijd

- Begeleide toegang gebruiken

- iPad-gebruik van kinderen beperken

- Geschikte apps voor oudere iPad zoeken

- Leerzame programmeerapps voor kinderen

- Tijdslot voor kinderen instellen op iPhone en iPad

- Thuisknop blokkeren op de iPad

- iPad-apps filteren op leeftijd

- iPad kindveilig maken met beschermhoezen

- Apps voor kinderen tijdens lange autoritten

- Meldingen uitschakelen op een gezamenlijke iPad

- In-app aankopen uitschakelen

- Alles over Delen met gezin

- Apple ID voor kinderen

Ze mogen van mij van alles scannen in de cloud (= hun eigendom) maar hebben helemaal niets te zoeken op mijn iPhone (= mijn eigendom)! Big Brother Federighi maakt zichzelf (en Apple) ongeloofwaardig nu de door Apple zo opgehemelde privacybescherming te grabbel wordt gegooid.

Apple blijft weg van de kern van de hele discussie:

– wie is Apple om te acteren als pollitie, openbaar ministerie en rechter (doorzoeken van [op] een telefoon is een gigantisch zware bevoegdheid, die nooit maar dan ook nooit aan een commerciële partij is).

– waar haalt Apple het lef vandaan om standaard op alle apparatuur een scanner te installeren, alle gebruikers verdachte te maken. Doelstelling van deze scanner is namelijk niks anders dan versleuteling te doorbreken en op basis van een database gebruikers te melden/blokkeren/….? Wat er in de toekomst/nu in de opsporingsdatabase staat weet niemand.

– Apple is niet in staat (technisch onmogelijk) misbruik van dit trojan framework uit te sluiten.

Dan kan de software chef van Apple nog zulke mooie termen gebruiken. Feit blijft dat Apple de stap maakt een spionage framework op de toestellen te implementeren. Wat een 180 graden verandering van koers. De privacy Company…. Google is er heilig bij. Zware teleurstelling dit.

Het is natuurlijk alleen maar goed dat er hard tegen kindermisbruik gestreden wordt. Maar voor mn gevoel wordt dit nu heel listig / strategisch ingezet om de fotoscanfunctionaliteit te legitimeren. Want hoe kan je nou tegen het opsporen van misbruik zijn…?

Apple maakt nu misbruik van de algehele publieke opinie mbt kindermisbruik om de functionaliteit te implementeren. Dat is next level manipulatie imo…

Interessant leesvoer, dit stuk van Alex Hern in The Guardian. Facbook, Google en Microsoft dit allang doen, maar dan met foto’s die in de cloud staan. Maar vooral dit is interessant (waarom lokaal en niet in de Cloud):

Twee onneembare vestingen: je telefoon en je icloud.

Ik ben er nog niet uit of het een goed zaak is (nou ja, bestrijding kinderporno is een goede zaak, de vraag is of dit de juiste manier is). Maar het lijkt me goed er genuanceerd naar te kijken, en het niet met oneliners af te doen.

Food for thought dus.

Dit stuk helpt dus.

@Jan Willem: cloud is zeker niet hun eigendom.

Daarnaast zaten ze hun privacy first houding volop te verkopen als unique selling point.

Dat vertrouwen hebben ze nu in 1 klap verloren.

Niemand heeft wat te zoeken in iPhoto of iCloud.

De volgende stap is dan ook al gezet, namelijk dat voor terrorisme hetzelfde mag met zgn. hashes. En dan voor misdaad. Kortom: iedere overheid, instantie mag dan voor goed bedoelde doeleinden je privacy schenden.

Als er een database gemaakt wordt voor iets met daarin hashes dan kunnen ze het ineens vergelijken met wat er in jouw telefoon of in je iCloud staat.

Wie bepaald dan welke hashes of welk algoritme goed is?

Ik bedoelde natuurlijk iCloud…

Hmmm… je mag van Apple dus kinderen misbruiken als je dat maar onder de 30 houdt… het blijft een zwak en onbegrijpelijk verhaal wanneer grijpen we nu eens in… dit is een taak de politie en niet voor Apple of Facebook… zij bepalen niet wat wij mogen doen of zien! Dat dien wij met z’n allen via ons parlement! Democratisch!

Dat wat in de cloud staat is ook van mij!

Een gruwel vind ik dit. Apple die door m’n photos heen gaat en de mogelijkheid heeft om er in te gaan kijken. Om wat voor een reden dan ook. Mocht dit in Nederland ingevoerd gaan worden dan gaan al m’n spullen uit de iCloud. Ik heb niks te verbergen, maar Apple heeft er niets, maar dan ook niets te zoeken. Dat is iets waar we de politie voor hebben.

Los van of wat Apple wil doen mag of slim is; iedereen lijkt niet in te zien dat Apple enkel foto’s DIE JE GAAT UPLOADEN naar iCloud scant op je toestel, VOOR ze naar iCloud gaan.

DAT doen ze lokaal.

Maar als er te veel verdachte hashes gevonden worden gaan ze wel degelijk de foto’s in iCloud zelf bekijken. En daar zul je vast al mee akkoord gegaan zijn toen je iCloud ging gebruiken…

Niet mee eens? Niet gebruiken! Maar dan ook helemaal niks in iCloud doen, ook geen agenda’s, backups of wat dan ook, anders zit je toch vast aan hun EULA lijkt mij…

Onwerkelijk. Dat een bedrijf denkt zich te kunnen permitteren de inhoud van particuliere iPhone bezitters te kunnen scannen.

Voor mij maakt het niet uit waarop er gescand wordt. Kindermisbruik is een gruwel maar maakt het nog niet tolerabel dat ieder zijn privé foto’s moet delen met één of andere firma. Het zijn dan niet eens privé foto’s meer maar een map van jezelf én Apple.

Dat er door instanties, politie, hackers en ongure landen na verloop van tijd ook gebruik van gemaakt gaat worden is een kwestie van tijd. Iets wat niemand wil.

Apple heeft zijn vertrouwen in privacy voor zijn gebruikers op straat gegooid.

Prachtige bescherming van je iPhone met oa. futuristische face herkenning terwijl aan de achterkant je foto’s worden nagekeken. Triest.

Ongelooflijk dat een leverancier zo misbruikt wil maken van MIJN toestel. Ik heb van alles in de iCloud staan, maar als dit door gaat, zeg ik dat 2TB abonnement wel op.

Ik had het begrepen als de iPhone foto’s zou scannen die ik ga delen (vind ik er nog wat van, maar terzijde). Dit is wel echt een brok in het vertrouwen..

Ik ben naturistisch en er zijn meer dan 30 foto’s van op m’n iPhone.. Ben ik nu verdacht? 😑

@Jan vdW: Het gaat erom dat Apple zich zo op de borst klopt als het gaat om privacy. Dit staat daar volgens mij haaks op. Dat geeft mij een zure smaak in m’n mond.

Het merendeel van jullie snapt er helemaal niks van. Er worden geen foto’s gescand. Er worden hashes vergeleken met een bestaande database met hashes van bekende foto’s.

Pas als je echt verdacht ben krijgt een Apple medewerker een lage resolutie foto te zien en dan worden bij positieve match de lokale autoriteiten ingeschakeld.

Ook wordt dit eerst in Amerika toegepast. Grote kans dat ze hier op de AVG stuiten.

Je iPhone is dan wel van jou, maar iOS dat op je iPhone staat is niet van jou!! Die software wordt niet aan jou verkocht door Apple maar blijft van Apple en mag je gebruiken. Vergelijk het met een boek. Dat is van jou, maar het verhaal is en blijft van de auteur.

In het artikel staat letterlijk dat alleen foto’s op iCloud gescand gaan worden, niet on device.

Als jouw foto’s ook in de internationale database met kinderporno staan: Zeker.

Vergelijk het met een huurhuis. Daar mag de huisbaas niet in je kasten woelen.

En wat betreft niet on device scannen… de reageerder die dat schrijft moet toch echt even lezen ipv uit de losse hand te schrijven.

– in iOS 15 zit een scanner die op je toestel foto’s tegen een database matcht voor dat deze naar iCloud gaan. Of die scanner actief is (in Europa) kan niemand zien en waar de scanner op matcht weet maar een heel klein clubje. Hoe een hacker dat spionage framework kan misbruiken is nog een ander verhaal.

Te roepen dat Apple alles mag omdat de software van hen is…met alle respect, dergelijke onzin lees je niet vaak.

Als dit een reactie is van mijn stukje;

ik zeg niet dat alles mag. Het is een reactie op personen die roepen dat het hun iPhone is. Dat klopt, maar de software is niet van hun. Dus als ze de iPhone willen blijven gebruiken dan is het of accepteren van deze functie, op een ouder iOS blijven of geen iPhone meer gebruiken.

Voor een groot deel bepaald Apple ook wat er met de iOS-sen gebeurt. Daar hebben wij weinig invloed op. Mss wel wat, maar erg weinig..