De afgelopen weken is er een constante stroom aan kritiek op Apple’s plannen om foto’s van gebruikers te scannen op kindermisbruik. Het is onderdeel van een grotere set maatregelen van Apple om verspreiding van kindermisbruik tegen te gaan. Diverse organisaties hebben individueel al kritiek geuit, waaronder experts van de Center for Democracy & Technology. Deze zelfde organisatie heeft nu een open brief opgesteld, samen met meer dan 90 andere organisaties wereldwijd. De kern van het verhaal is dat ze hopen dat Apple afziet van haar plannen.

Open brief aan Apple: “Stop met plannen om foto’s te scannen”

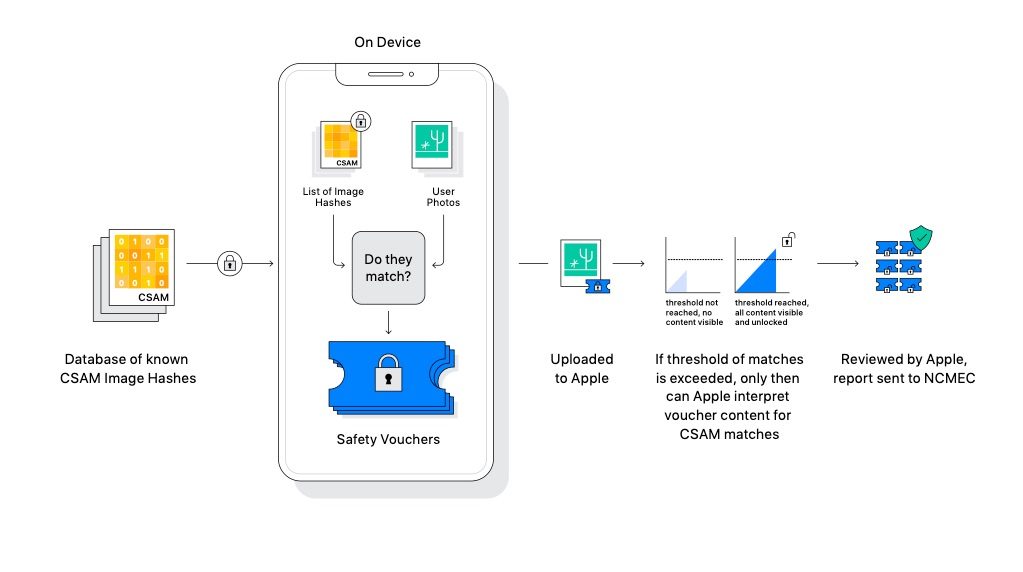

In de brief ligt de focus op twee punten: het scannen van mogelijk schadelijke foto’s in iMessage en het scannen van de foto’s voor het detecteren van CSAM (Child Sexual Abuse Material). Hoewel de functies voorlopig alleen nog gepland staan voor de VS, hebben organisaties vanuit allerlei landen zich bij de open brief aangesloten. Namens Nederland heeft Global Voices zich bijgevoegd. Deze organisatie doet wereldwijd verslag over mensenrechten en burgermedia.

De organisaties zijn bang dat het mogelijk maken van CSAM-detectie in iCloud-foto’s een precedent schept voor andere manieren van surveillance. Volgens de open brief kan Apple onder grote druk worden gezet door landen, overheden en regelgeving om ook andere vormen van scans mogelijk te maken. Apple heeft eerder al in zijn eigen FAQ gezegd dat de functie uitsluitend en alleen bedoeld is voor het detecteren van kindermisbruik en dat aan andere verzoeken geen gehoor gegeven zal worden. Maar de organisaties in de open brief denken niet dat Apple die garantie kan geven. Apple legt de fundering voor verdere controle en censuur, zo is de beredenering.

Bovendien denken de organisaties dat de waarschuwingsfunctie in iMessage kinderen juist in gevaar brengt. Met name LGBTQ+ jongeren met ouderen die niet tolerant zijn, zouden hierbij gevaar kunnen lopen. Ouders moeten deze functie zelf inschakelen. Bovendien gaat het systeem er vanuit dat ouders en het kind een goede relatie hebben. Dat is in de praktijk niet altijd het geval, zo staat in de brief. Dat kan zorgen voor meer scheve verhoudingen en gevaren voor het kind.

De volledige brief van de organisaties is hier te lezen. Het is afwachten of Apple nog iets gaat doen met de kritiek op de plannen. De afgelopen weken heeft Apple geprobeerd in interviews uit te leggen hoe het systeem werkt en dat het niet misbruikt kan worden. Maar met zoveel kritiek van diverse organisaties, kan Apple bijna niet anders dan reageren en actie ondernemen.

Meer over Apple’s maatregelen

Ook onder Apple’s eigen medewerkers is kritiek op het scannen van foto’s op kindermisbruik, zo bleek eerder deze week al. Lees ook onze FAQ over CSAM-detectie en fotoscannen om meer te lezen over hoe het systeem werkt.

Taalfout gezien of andere suggestie hoe we dit artikel kunnen verbeteren? Laat het ons weten!

Het laatste nieuws over Apple van iCulture

- Apple geeft je 10% korting op accessoires bij inlevering van je oude apparaat (van welk merk dan ook) (16-04)

- Apple werkt aan verbeteringen voor Apple Intelligence: zo gaat Apple dat doen (15-04)

- Apple is voor het eerst grootste smartphoneverkoper ter wereld in eerste kwartaal (dankzij deze iPhone) (15-04)

- Apple viert 10 jaar Activiteit-app met speciale uitdaging (en een exclusieve fysieke pin) (14-04)

- Gerucht: 'Apple Intelligence-versie van Siri komt nog dit najaar' (14-04)

De iPhone en iPad voor kinderen

De iPad en iPhone zijn ook leuk voor kinderen. Met deze artikelen zorg je dat kinderen ze veilig kunnen gebruiken, met onder andere informatie over delen met gezin, ouderlijk toezicht, tijdslot instellen en leuke apps vinden. En met Schermtijd beperk je de tijd die kinderen (of jijzelf) kunnen doorbrengen op de iPhone en iPad. Ook lees je hoe je een Apple ID voor kinderen kunt aanmaken.

- Ouderlijk toezicht gebruiken

- Schermtijd op iPhone en iPad

- Applimieten instellen in Schermtijd

- Begeleide toegang gebruiken

- iPad-gebruik van kinderen beperken

- Geschikte apps voor oudere iPad zoeken

- Leerzame programmeerapps voor kinderen

- Tijdslot voor kinderen instellen op iPhone en iPad

- Thuisknop blokkeren op de iPad

- iPad-apps filteren op leeftijd

- iPad kindveilig maken met beschermhoezen

- Apps voor kinderen tijdens lange autoritten

- Meldingen uitschakelen op een gezamenlijke iPad

- In-app aankopen uitschakelen

- Alles over Delen met gezin

- Apple ID voor kinderen

Het lijkt wel of deze organisaties bang zijn dat het Apple juist lukt en dat ze het kindermisbruik via iMessage voor een groot deel echt plat kunnen leggen.

Ik snap het hele privacy gedoe, maar als dit op een bepaalde manier wordt gedaan zonder privacy gevaar en het doel wordt bereikt is dit toch een goede zaak? En wat anderen dan op een bepaalde andere manier eventueel hierna willen gaan doen wordt dan toch weer bekeken en opnieuw beoordeelt.

Wat is de goede zaak? Dit zal een geleidende schaal worden en telkens worden opgerekt. Kortom opsporing overlaten aan aangewezen functionarissen in het rechtssysteem. Niet door commercianten.

Ik verwacht van Google da ze zoiets constant doen, maar nie van Apple.

Blijf van mijn foto’s af, die zijn privé.

Wat een rare opmerking. Je snapt het “privacy gedoe” dus compleet niet.

Het gaat Apple op deze manier sowieso niet lukken misbruik te voorkomen.

Ten eerste: de iMessage trojan-scan functie rapporteert foto’s (nog) uitsluitend naar ouders. Deze gaan dus niet richting Apple. Het “privacy gedoe” hierin is dat Apple de encrypted iMessages dus gaat openbreken, ze gaan de berichten op de toestellen scannen. Misbruik van een dergelijke framework is meer dan mogelijk, daarnaast kan Apple op ieder moment gehoor geven gevonden inhoud (van foto’s tot kritische opmerkingen of anderszins vertrouwelijke info) wel naar derden te rapporteren/toegang mogelijk te maken.

De fotobibliotheek trojan functie scant foto’s op het toestel voor de upload richting iCloud op een near-hash database. Wat er in die hash database zit, wat er in gaat zitten, wanneer hij aanslaat, niemand behoudens een enkeling weet het. Zet je iCloud foto’s uit blijft het trojan gedeelte gewoon in iOS zitten. Misbruik is gewoon mogelijk.

Voor beide functies geldt dat Apple in principe iedereen verdachte vindt, bewakingssoftware installeert, je toestel actief gaat doorzoeken. Nu nog alleen voor iCloud foto’s, morgen op … zeg het maar. Apple is een barrière aan het doorbreken die weergaloos is. En dat als voorheen “vechter voor privacy”. En dat is waar het om gaat. Vanaf iOS 15 heeft jouw telefoon een ingebouwde controleur die van alles op de achtergrond, onzichtbaar uitvoert en rapporteert indien de ki/ai het nodig acht. Apple heeft niks te doorzoeken en te rapporteren op mijn toestel, nog mij verdachte te maken.

Gelukkig is er stevige opstand op alle fronten. Journalisten verenigingen, bedrijven (dit maakt bedrijfsspionage wel heel heel erg makkelijk), overheden (zitten ook niet te wachten op een telefoon met trojan). Hopelijk komt dit goed, tot die tijd sla ik mijn jaarlijkse iPhone en iWatch vervanging over. Aan de andere kant ben ik “bang” dat Apple op zijn Apple’s lak aan alles heeft en denkt… ach onze fanboys betalen altijd de hoogste prijs en blijven toch wel kopen, wat wij ook doen.

Dit is het Begin van het Eind !

Dom, dom,dom !

Lijkt me goede zaak

Zoals apple het zegt scannen op kindermisbruik

Apple mag van mij best mijn foto’s scannen die in de cloud staan maar niet via geïnstalleerde spyware die op mijn toestel wordt gezet en waar ik zelf niks over te zeggen heb. Als ze daar toch mee door willen gaan dan neem ik afscheid van Apple. Een dergelijk functie in Europa is voor Apple toch al redelijk nutteloos gezien hun marktaandeel van iets meer dan 19%. Daarnaast staat dit helemaal haaks op hun eigen privacybeleid. Tim Cook hoeft voor mij niet te beslissen wat wel of niet door de beugel kan, dat kan ik zelf heel goed. Dus beste Tim, als jij wil dat ik in december een iPhone 13 koop en een nieuwe Watch, stop dan met deze onzin en verzin wat anders.

Ik vind dit wel een verhelderend interview over wat er nou feitelijk bedacht is en hoe het werkt.

Ik probeer me voor te stellen wat voor akelige functie je bij Apple hebt om dit te controleren… foto’s in te scannen en hier een algoritme van te maken.. 🤢

De wereld is ziek. Ernstig dat hier überhaupt manuren in gestoken moeten worden, maar ik ben al een tijdje bewust dat er duistere zaken zijn rondom kinderen/mensenhandel.

Treurig.

. Probleem is dat men dit niet alleen voor kinderabuse kan gebruiken maar voor alles waar de AI voor wordt ingezet. En dan bepaalt de AI wat fout is en jij moet je daarna daarin verdedigen. Een onschuldige foto van je kind van 3 jaar in een zwembadje kan dan al voldoende zijn. Wie bepaald de grenzen? Wie zijn diegene die denken dit te kunnen bepalen? En denk je werkelijk dat Apple zo machtig is dat ze iedere wereldmacht het hoofd kunnen bieden?

Alleen al het feit dat men dit aankondigde toont denk ik aan dat ze de mogelijkheid al hebben en kunnen gebruiken.

Als je foto aan bepaalde kenmerken voldoet gaat iemand van Apple deze bekijken……wie dan ??

Als er in Nederland iets gebeurd in het OV mag het bedrijf de video niet eens bekijken !!

Er moet eerst aangifte gedaan zijn en dan pas mogen speciale afdelingen deze gaan bekijken en dan alleen in het tijdspad van de aangifte.

Ik ben van mening dat dit soort onderzoeken naar criminaliteit, want daar valt kindermisbruik onder, niet door een bedrijf als Apple gedaan zou moeten worden maar door de politie. Ik zou het zelf niet erg vinden als Apple mijn foto’s hierop zou scannen maar waar ligt dan op een gegeven moment de grens. Het begint er inmiddels wel op te lijken dat Tim zich alleen met andere zaken bezig houdt dan het bedenken, vernieuwen etc. van Apple producten en dat vind ik wel een schadelijke zaak voor Apple.

Dit is een uitstekende opmerking. Er is niet voor niets wet en regelgeving voor. Ik vind dat als er redelijk aan te nemen misbruik is, dat de overheid makkelijker in staat moet zijn om dit request bij Apple te doen. Pas dan wordt er iets geüpload of iets dergelijks.

Wat is er gebeurd met: je bent onschuldig zo lang tegendeel bewezen is. Tech is nu judge, jury & executioner.

Ik ben voorstander van het aanpakken van kindermisbruik. Maar ik denk niet dat dit de manier is. Ook al begrijp ik de onderliggende techniek wel en valt het allemaal wel mee wat ze doen. Op dit moment… wat doen ze in de toekomst? Drugs? Alcohol? Sigaretten? Grote hoeveelheden geld op foto’s?

Niemand bekijkt een foto. En niemand kan je foto’s bekijken in de iCloud. Het gaat alleen om een hash vergelijking uit een database met kinderporno en degene die op je telefoon staat.

Wat een gezeur

Vol van onwaarheden:

– foto’s in iCloud zijn niet end to end encrypted, kunnen en worden al lang geautomatiseerd bekeken en bij twijfel handmatig door Apple

– het gaat niet om een hash, maar een neural hash (moderne Apple term voor een ordinaire near hash). Bij voldoende near hash hits worden ook deze foto’s handmatig bekeken.

– je laat het hele geïmplementeerde framework, scannen op toestel compleet uit je verhaal.

Met andere woorden:

Of je snapt totaal niet waar het over gaat. Of je bent het type “fan boy”. Aan jou volledig het recht dit “gezeur” te vinden, maar baseer je reacties dan op feiten.

@Jaap Couro: Feit

Wie denkt dat hij of zij nog privacy heeft is er al lang aan voor de moeite. Uiteindelijk als je niks verkeerd doet heb je niks te vrezen. Ik lees hier een heel gedoe errond van privacy maar al eens stilgestaan hoeveel je zonder die telefoon nog privacy hebt? Nada niks, overal hangen er camera’s op het werk, openbare en privé domeinen en vervoer, je internet provider weet heel goed wat en hoeveel je download thuis van het internet maar geen haan die daar naar kraait. Dus voor mij geen probleem hoor dat ze me scannen heb niks te verbergen.

@Vincent: Als je alles wat Apple zegt op hun blauwe ogen wilt geloven en niet verder kijkt, en negeert dat er vele organisaties ter wereld het verzoek aan Apple hebben gedaan om het framework voor het scannen niet te gaan implementeren vanwege mogelijke andere gevolgen, dan komt dit antwoord toch wel een beetje naïef over. Persoonlijk ben ik bijzonder teleurgesteld in Apple, alleen al vanwege de overweging om dit op deze manier te doen. Het geeft wel goed aan met wat voor personen je in werkelijkheid hebt te doen. In ieder geval hebben ze de mentaliteit om iedereen te willen controleren. Eigenlijk heb ik al besloten om helemaal met Apple te gaan stoppen (iPhone, Watch, Tablet en Mac). Met deze actie is het vertrouwen bij mij in één keer weg.

@Vincent: Heerlijk, en exact daar staat dat bijvoorbeeld foto’s niet end to end encrypted zijn. Apple heeft een master key voor heel veel functies van jouw cloud (en van sommige niet). Eerst lezen, dan snappen, dan posten.

Eigenlijk zonde tijd tegen dit soort non uitspraken te argumenteren. Maar ok…. Als je niks verkeerd doet heb je niks te vrezen. En wat is de definitie van verkeerd? Wie bepaalt dat? Wat in Nederland niet verkeerd is, is elders reden voor de cel of erger. Dus Apple gaat voor jou bepalen, op jouw toestel wat verkeerd is. Fotografeer 3x een Snickers en je zorgverzekering komt naar je toe dat je niet langer welkom bent? Of jij wat te verbergen hebt weet jij helemaal niet. Misschien is die mooie foto op een vakantie wel reden jou van straat te trekken. En je uitspraak “hoeveel je zonder die telefoon nog privacy hebt” schopt je hele verhaal omver hé…. Met trojan is die privacy waar je het over hebt weg. Apple als politieagentje op jouw toestel. En wat betreft die isp… ook al onzin. Het internet beschermt met https, anonieme dns, vpn aardig goed tegen wat jij aandraagt. Maar ok, de uitspraak “ik heb niks te verbergen laat Apple maar scannen” zegt eigenlijk genoeg. Laat jij je telefoon en MacBook lekker scannen en bekijken. Misschien kun je ook je voordeur open zetten en iedere passant uitnodigen je hebben en houden te doorzoeken? Je hebt immers niks te verbergen en zo weten wij dat jij geen criminele activiteiten uitvoert.

Dat wordt in landen als China, Iran, Afganistan en meer, ook tegen de bevolking gezegd, maar het werkelijke probleem heb jij in ieder geval niet begrepen. Dit heeft niks te maken met of je iets te verbergen hebt, want vrijwel niemand heeft er problemen mee als foto’s worden gescand. Het gaat om de manier hoe dat gebeurd en wat de mogelijke gevolgen ervan kunnen zijn. Maar ik zou zeggen: lees de commentaren eens goed door, wellicht begrijp je het dan.

Wat ik me wel altijd afvraag, wat is het alternatief? Mensen roepen weer massaal weg te lopen van Apple.

Begrijp me niet verkeerd, ik ben ook geen voorstander van wat Apple nu heeft bedacht/wilt gaan gebruiken want zover is het nog niet.